Maschinenbilder: Gescannte und sortierte Menschen

Die Ausstellung «Training Humans» zeigt plastisch und drastisch, wo die Forschung zur Gesichtserkennung steht. Dabei erfährt man auch, warum menschliche Vorurteile in der künstlichen Intelligenz weiterhin das Hauptproblem darstellen.

Was kann man aus einem Gesicht alles herauslesen? Sprichwörtlich ist die Behauptung, die Augen seien nichts weniger als ein Spiegel der Seele. Auf der wissenschaftlichen Nachtseite solch romantischer Vorstellungen warten die Phrenologie als Lehre von den unterschiedlichen Schädelformen und die Physiognomie, also die Annahme, dass Gesichtszüge und Mimik auf Charakter und Gefühlswelt eines Menschen schliessen lassen. Im 19. Jahrhundert wurden solche höchst fragwürdigen Theorien im Fahrwasser von Rassenlehren, Neurologie und Kriminalistik sehr beliebt: der menschliche Kopf als Zeichensystem, das man mit dem geeigneten Schlüssel ganz einfach dekodieren kann. In der zweiten Hälfte des 19. Jahrhunderts hat auch das neue Medium Fotografie rasch technische Fortschritte gemacht und sich immer weiter verbreitet.

Es ist keine kleine Leistung der Ausstellung «Training Humans» über fotografische Bilder im Dienst künstlicher Intelligenz (KI), dass sie solche historischen Zusammenhänge stets mitdenkt – und dabei doch ganz nahe an den brennenden Fragen der Gegenwart bleibt. Im Observatorium der Fondazione Prada in Mailand präsentieren die australische Wissenschaftlerin Kate Crawford und der US-Künstler und Forscher Trevor Paglen auf zwei Etagen ihre mehrheitlich fotografischen Rechercheresultate zum Thema «Maschinenbilder und Gesichtserkennungssoftware». Die politische Geschichte, die sich aus den Exponaten und der unentbehrlichen Begleitpublikation in Form eines Interviews mit Crawford und Paglen herausschält, birgt Zündstoff. Und dies, obwohl sie weder simple Antimaschinenreflexe bedient noch das Ende der Menschheit an die Wand malt. KI wird aber auch nicht einfach als Heilsbringerin gefeiert.

Militärische Geheimhaltung

Die Ausstellung empfängt uns mit einem im Raum hängenden, riesigen Fingerabdruck. Und auf der Rückseite dieser alten Identitätssignatur: ein Auge. Anstelle der Fingerkuppe werden heute die Spiegel der Seele gescannt. Maschinen haben dabei aber kaum Sinn für Sinnliches oder Metaphorik. Sie benötigen Quantifizierbares, mathematisch vergleichbare Abstraktionen, Zahlen. Deshalb lautet die Ausgangsfrage der Maschine auch nicht: Was kann ich aus einem Gesicht herauslesen, sondern: Was ist das überhaupt, ein Gesicht? Die kurze Antwort darauf: eine vermessbare Ansammlung von Bildpunkten.

Bereits 1963 hatte die CIA zwei Studien finanziert, die sich mit automatisierten Bildanalysen von menschlichen Antlitzen beschäftigten: theoretische Vorarbeiten zur Konstruktion einer «vereinfachten Gesichtserkennungsmaschine». In «Training Humans» sind nur ein paar geleakte Auszüge zu sehen, beide Studien stehen bis heute unter militärischer Geheimhaltung.

Ebenfalls in einer militärischen Forschungsanstalt ist in den 1990er Jahren die «Feret Database» entstanden: eine Porträtgalerie mit SoldatInnen, Verwaltungspersonal und anderen Assoziierten der US-Armee, die sich zum Teil sichtlich herausgeputzt hatten wie für einen wichtigen Fototermin. Diese insgesamt 14 000 Porträts von mehr als 1000 Menschen waren jahrelang die Standardsammlung, die benutzt wurde, um Gesichtserkennungssoftware mit konkreten Bilddaten zu füttern und so deren Lesefähigkeiten zu «trainieren».

Eine weitere, sehr viel problematischere Quelle sind Polizeifotos von wiederholt Verhafteten. An ihnen wurde unter anderem untersucht, wie Gesichter über die Jahre altern. Dazu kommen «wissenschaftliche» Versuchsreihen mit Menschen, die man anwies, eine reduzierte Palette von Gefühlsregungen (Wut, Angst, Überraschung, Glück, Abscheu und Trauer) in zugespitzten Gesichtsausdrücken nachzuspielen. An diesen Bildern zeigt sich allerdings vor allem die Künstlichkeit der Versuchsanordnung – und dass mimische Übersetzungen von Emotionen oft sehr unterschiedlich ausfallen können. Einen gemeinsamen mimischen Nenner etwa für Wut zu finden, scheint unmöglich.

Prominentes Fotofreiwild

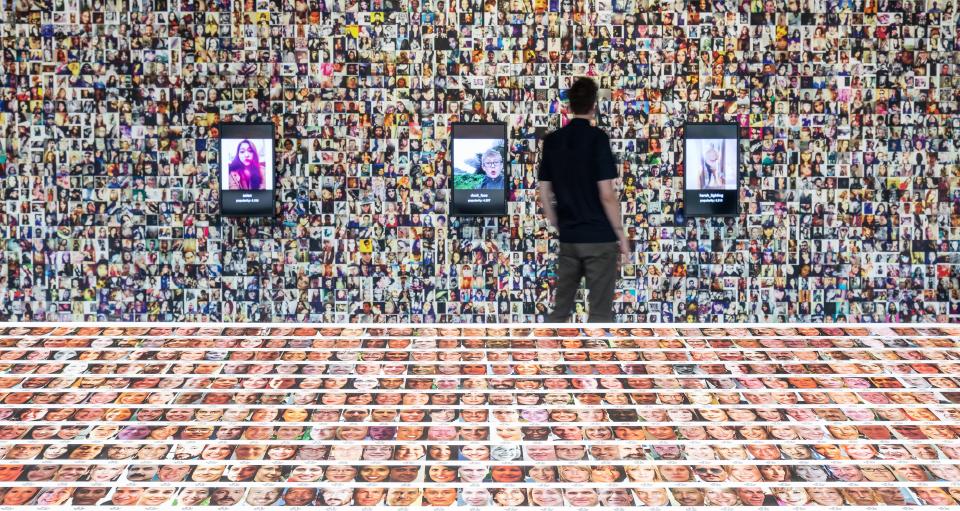

Crawford und Paglen zeichnen nach, wie solche zwar weder harmlosen noch neutralen, aber immerhin überschaubaren Porträtbilderarchive mit der Ankunft von Social Media durch einen nie versiegenden und unkontrollierten Bilderfundus erweitert wurden. Plötzlich luden Abermillionen von Menschen freiwillig private Bilder von sich hoch und beschrifteten diese auch gleich noch. Hier wuchs ein schier unendlicher, in grossen Teilen frei zugänglicher Bildbestand heran, an dem sich die PorträtjägerInnen der KI-Forschung hemmungslos bedienten. Ein weiterer beliebter Gesichtserkennungsrohstoff: Prominente als viel geknipstes Fotofreiwild.

Zehntausende solche zusammengerafften Bilder werden seit 2009 im Rahmen des «Image Net»-Projekts der Eliteuniversitäten Stanford und Princeton von oft schlecht bezahlten AkkordarbeiterInnen mit harmlosen, aber auch hochproblematischen und willkürlichen Labels wie «Juristin», «Boxer», «Sodomit», «Maulheld», «Alkoholikerin» oder «Bolschewik» versehen und dann in die Gesichtserkennungsalgorithmen eingespeist. Rassistische, sexistische und moralische, oft auch schlicht gedankenlos oder zufällig verteilte Vor- und Fehlurteile werden so direkt in die Software eingeschrieben. Bereits die ursprüngliche Bilderauswahl ist alles andere als neutral, sondern verformt von Vorlieben und blinden Flecken der Forschenden. Um Erlaubnis gefragt wurden die Fotografierten ebenfalls nie.

Die Schlussfolgerung drängt sich auf: Das Hauptproblem sind hier nicht die Maschinen, sondern die Interpretationen und Wertungen, die Menschen in unmenschlicher Fliessbandarbeit in sie hineinprogrammieren. Und auch die Gespenster des 19. Jahrhunderts sind in diesen digitalen Bildersammlungen plötzlich wieder da: Gesichter, Körperhaltungen und Mimik erscheinen erneut als eindeutige Signaturen von Charakter und Herkunft. Und im Gegensatz zu künstlerischen Abbildungen oder auch Alltagsfotografien, deren Interpretation stets wandelbar bleibt, ist bei diesen Maschinenbildern das meist zufällige Werturteil plötzlich starr fixiert. An einem Porträt haftet nun auf immer ein einziges krudes Label: Unruhestifter oder Wohltäterin, Verliererin oder guter Junge.

Dass in diesen KI-Systemen die Menschen der Hauptrisikofaktor sind, hat vor Jahren auch schon der Chatbot Tay von Microsoft gezeigt. Man hatte ihn quasi als Spiegel seiner Umgebung programmiert. Im Netz wurde er mit so viel Hass, Fake News und Verschwörungstheorien zugemüllt, dass er nach nur einem Tag selbst wie ein durchgeknallter, rechtsradikaler Troll wütete und sofort abgeschaltet werden musste.

Überwachung der Überwacher

Trevor Paglen macht Kunst an der Schnittstelle von investigativer Recherche und Wissenschaft: kritische Kunst, die oft kaum noch markttauglich ist und deshalb wie Forschung subventioniert werden muss. Allgemein gefasst geht es in Paglens Projekten stets um eine Überwachung der Überwacher – etwa indem er Abhörsatelliten, Tiefseekabel oder geheime CIA-Gefängnisse und Militärprogramme fotografiert. In «Training Humans» öffnet er nun die Blackbox der bilderlesenden Maschinen. Gemeinsam mit Kate Crawford hat er als anschauliche Momentaufnahme des Forschungsstands auch eine – inzwischen abgeschaltete – Website erstellt. Menschen konnten dort ihr Gesicht hochladen und «interpretieren» lassen und wurden dabei prompt mit den ins «Image Net» eingeschriebenen Vorurteilen konfrontiert: Viele waren schockiert. Auch die in der Ausstellung aufgestellte Gesichtsinterpretationskamera liefert zweifelhafte Resultate: Oft erkennt sie nicht einmal das Geschlecht der Gescannten korrekt. Zeitgleich mit den Ausstellungsrecherchen zum «Image Net» blockierten die ForscherInnen in Stanford übrigens den Download ihrer Gesichtssammlung. Zufall? Heute heisst es, viele «Image Net»-Bilder würden gelöscht werden.

Man muss für diese Ausstellung nicht extra nach Mailand fahren. Wer in der Nähe ist, sollte sich «Training Humans» aber anschauen. Die Exponate sind visuell unspektakulär – es sind hauptsächlich Tausende der erwähnten, für Maschinenaugen aufbereiteten Porträts. Umso brisanter sind die Fragen, die sie auslösen. Am Ende ist man ernüchtert – und extrem skeptisch: Lässt sich überhaupt etwas Verlässliches aus einem fremden Gesicht herauslesen?

«Training Humans» ist noch bis 24. Februar 2020 im Osservatorio der Fondazione Prada in Mailand zu sehen. www.fondazioneprada.org